Emotion AI in der Nutzerforschung: sinnvolle Ergänzung oder überflüssig?

Worum geht’s?

In unserem evux Lab verfolgen wir stets neue Technologietrends. Schon seit längerem haben wir die Technologie «Emotion AI» für die Nutzerforschung auf unserem Radar, welche unsere AINO neu inpetto hat. Jetzt haben wir sie genauer unter die Lupe genommen. Wir haben uns gefragt, was kann die Emotion AI, was nützt sie, wo sind die sinnvollsten Einsatzmöglichkeiten, wo sind die Grenzen oder ist sie gar überflüssig? Das und mehr erfährst du in diesem Artikel.

Was ist Emotion AI und wie funktioniert sie?

Emotion AI, auch bekannt als Affective Computing, ist eine Technologie, die darauf abzielt, menschliche Emotionen zu erkennen, zu verstehen und darauf zu reagieren. Stell dir vor, dein Computer könnte nicht nur verstehen, was du sagst, sondern auch merken, ob du gestresst, glücklich oder frustriert bist – genau das versucht Emotion AI zu erreichen. Im Unterschied dazu messen bisherige Sensortechnologien wie z.B. Eye-Tracking primär, wohin und wie lange du schaust; es erfasst also vor allem Aufmerksamkeit und Blickverläufe und nicht direkt deine Gefühle. Emotion AI kann Eye-Tracking zwar als zusätzliche Datenquelle nutzen, geht aber einen Schritt weiter, indem es verschiedene Signale – etwa Mimik, Stimme oder physiologische Daten – kombiniert, um daraus einen emotionalen Zustand abzuleiten.

Die Technologie nutzt verschiedene Ansätze, um unsere Gefühlswelt zu entschlüsseln. Kameras analysieren Gesichtsausdrücke und können erkennen, ob jemand lächelt, die Stirn runzelt oder überrascht aussieht. Mikrofone hören nicht nur die Worte, sondern auch den Tonfall – ist die Stimme angespannt, müde oder aufgeregt? Sensoren messen sogar körperliche Reaktionen wie Herzschlag oder Hautleitfähigkeit, die sich bei verschiedenen Emotionen verändern. All diese Daten werden von intelligenten Algorithmen ausgewertet, die Muster erkennen und daraus auf den emotionalen Zustand schliessen.

Die Anwendungsmöglichkeiten sind vielfältig und teilweise schon heute Realität. In der Automobilindustrie überwachen Systeme die Müdigkeit von Fahrern und warnen bei Erschöpfung. Kundenservice-Chatbots versuchen zu erkennen, wann ein Kunde frustriert ist und passen entsprechend ihre Antworten an. Die Einsatzmöglichkeiten sind vielfältig – auch bei der Nutzerforschung.

Wozu Emotion AI in der Nutzerforschung?

Emotion AI gewinnt in der Nutzerforschung an Bedeutung, weil klassische Methoden häufig nur bewusst wahrgenommene und verbalisierbare Emotionen erfassen. Interviews oder Fragebögen zeigen oft ein unvollständiges Bild, da Nutzende nicht immer in der Lage oder bereit sind, ihre wahren emotionalen Reaktionen auszudrücken. Studien zeigen, dass qualitative Selbstauskünfte und quantitative physiologische Messungen systematisch unterschiedliche Ergebnisse liefern: Während Fragebögen im Video-Experiment keine Unterschiede zwischen Stimuli erkennen liessen, zeigten biologische Daten deutliche emotionale Reaktionsunterschiede (Larsen & Fredrickson, 1999).

Dies verdeutlicht den Mehrwert von Emotion AI: sie kann unbewusste, kontinuierliche und feinere emotionale Signale erfassen, die traditionelle Methoden übersehen. Darüber hinaus eignet sie sich besonders, wenn unbewusste Affekte oder zwischen Personen vergleichbare Muster relevant sind. Emotionale Messverfahren enthüllen häufig zusätzliche Einsichten – etwa in Usability-Studien, in denen konventionelle Metriken keine Unterschiede zeigen, emotionale Reaktionen jedoch sehr wohl.

Ein kurzes Beispiel: Ein Automobilhersteller testet das Design eines neuen Armaturenbretts. Während die Befragung nach der Fahrt durchweg positive Bewertungen (z.B. modern, intuitiv) liefert, erfasst die Emotion AI (durch Eye-Tracking und physiologische Sensoren) während bestimmter Interaktionen kurze Spitzen an Stress und Verwirrung. Diese unbewussten physiologischen Reaktionen deuten auf ein gestörtes Aufmerksamkeitsmuster z.B. bei der Bedienung der Klimaanlage hin, obwohl der Fahrer dies im Nachhinein nicht erwähnte.

Indem Emotion AI qualitative und quantitative Daten verbindet und sowohl bewusste als auch unbewusste Ebenen berücksichtigt, ermöglicht sie ein umfassenderes Verständnis des Nutzererlebens und unterstützt fundiertere Designentscheidungen.

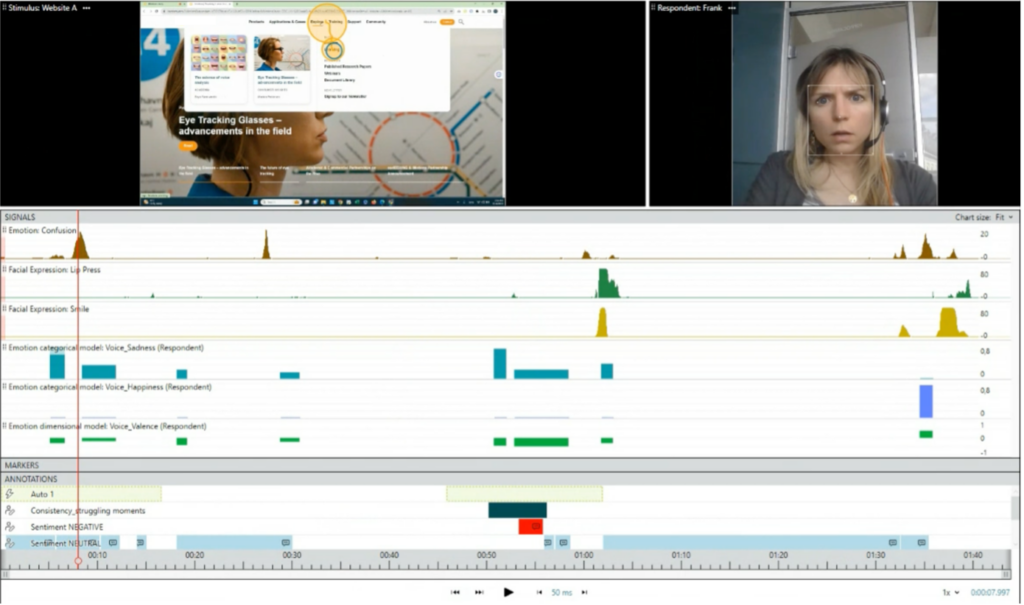

Erfassung von Emotionen durch AI bei einer Remote-Aufnahme

Welche Forschungsmethoden sind mit Emotion AI besonders interessant?

Im klassischen Usability Testing kann die Gesichtsausdrucksanalyse bereits Frustration oder Verwirrung zeigen, bevor diese artikuliert wird. Hochgezogene Augenbrauen, ein leichtes Stirnrunzeln oder unbewusste Mikroexpressionen verraten Schwierigkeiten mit der Benutzeroberfläche, noch während Testpersonen versuchen, eine Aufgabe zu lösen. Diese Erkenntnis ist besonders wertvoll, da viele Nutzer dazu neigen, Probleme herunterzuspielen oder höflich zu bleiben.

Besonders kraftvoll wird der Ansatz bei der Kombination von Eye-Tracking und Emotionserkennung. Hier können wir nicht nur erfahren, welche Bereiche der Oberfläche Aufmerksamkeit erhalten, sondern auch, welche emotionalen Reaktionen diese auslösen. Ein überraschter Gesichtsausdruck bei einem unerwarteten Element kann aufschlussreicher sein als jede nachträgliche Befragung, da er die spontane, unzensierte Reaktion einfängt.

A/B Testings können ebenfalls von emotionalen Erkenntnissen ergänzt werden. Während klassische Metriken wie Klickraten oder Conversion-Zahlen funktionale Unterschiede zwischen Varianten aufdecken, zeigt Emotion AI, welche Version positive Gefühle auslöst. Zwei Varianten mögen gleich gut funktionieren, aber nur eine schafft es, Nutzer emotional zu erreichen – ein entscheidender Faktor für langfristige Nutzerbindung.

User Interviews gewinnen durch die Integration von Gesichtsausdrucksanalyse, Spracherkennung und textbasierter Emotionserkennung eine neue Qualität. Gerade bei Remote-Sessions, wo nonverbale Signale oft verloren gehen, kann die Technologie die wahren Gefühle hinter den gesprochenen Worten enthüllen. So werden Diskrepanzen zwischen dem, was gesagt wird, und dem, was tatsächlich empfunden wird, sichtbar.

Selbst bei strukturierten Methoden wie Card Sorting kann Emotion AI wertvolle Zusatzinformationen bieten. Nutzer mögen Karten korrekt gruppieren, aber ihre Gesichtsausdrücke verraten, ob diese Prozesse intuitiv und angenehm oder mühsam und verwirrend waren. Diese emotionale Dimension der Nutzererfahrung bleibt bei rein funktionalen Erfolgsmetriken oft unsichtbar.

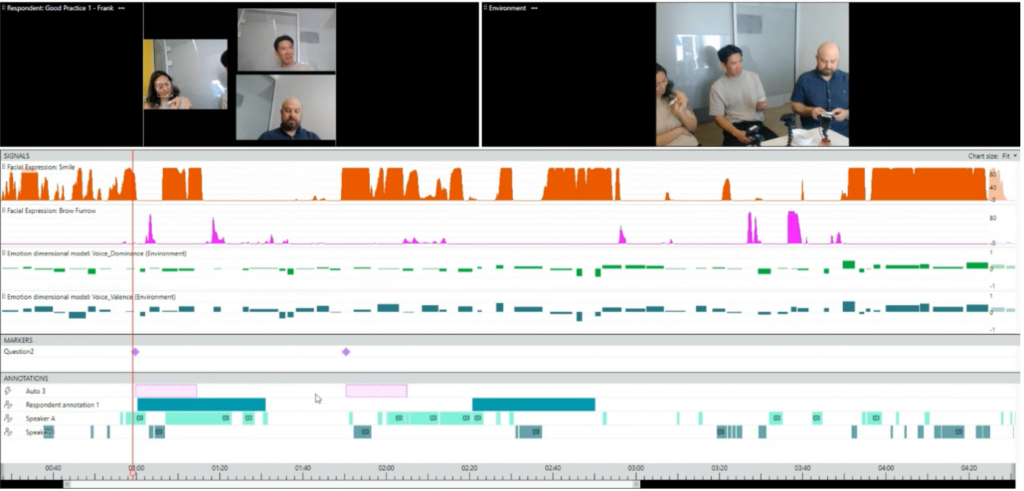

Erfassung von Emotionen durch AI bei einer Gruppe

Wie geht es weiter?

Uns hat die Technologie definitiv neugierig gemacht und wir möchten die neuen Fähigkeiten unserer AINO in einer konkreten Nutzerforschung einsetzen. Dabei fragen wir uns vor allem:

- Erhalten wir durch die Emotion AI ein anderes Bild von der Test-Session als durch unsere menschlichen Beobachtungen?

- Deckt die Emotion AI Aspekte auf, die mit klassischen Methoden der Protokollierung und Auswertung unentdeckt geblieben wären?

- Lassen sich durch die Ergebnisse der Emotion AI neue oder ergänzende Handlungsempfehlungen ableiten?

Wir sind bald zurück mit den Ergebnissen. Sei gespannt!

Quellen:

Anshu Agarwal & Andrew Meyer (2009)

«Beyond Usability: Evaluating Emotional Response as an Integral Part of the User Experience»

Cong Liu, Paul Spector & Lin Shi (2008)

«Use of Both Qualitative and Quantitative Approaches to Study Job Stress in Different Gender and Occupational Groups»

Gaming-Studie: Robinson, Murray & Isbister (2018)

«You’re Giving Me Mixed Signals!: A Comparative Analysis of Methods That Capture Players’ Emotional Response to Games»

Larsen, & Fredrickson (1999)

«Well-Being: The Foundations of Hedonic Psychology»

Pierluigi Reali et al. (2017)

«Integrated Data Analysis for the Quantification of Emotional Responses During Video Observation»